DIARIO ABC, CIENCIA SCIENCE China acaba de lograr la supremacía cuántica. Es decir, sus investigadores han conseguido crear un sistema cuántico tan potente que realiza una tarea casi imposible de llevar a cabo con los ordenadores clásicos. En concreto, el equipo llamado Jiuzhang ha podido resolver en tan solo 200 segundos un problema que al superordenador clásico más avanzado del mundo, la supercomputadora japonesa Fugaku, le costaría 600 millones de años en completar. Un hito, no exento de polémica, que se logra por segunda vez en la historia, después de que Google, con su chip Sycamore, lograra lo mismo en octubre de 2019. Los resultados acaban de publicarse en la revista « Science». La proeza del equipo dirigido por Jian-Wei Pan, de la Universidad de Ciencia y Tecnología de China, reside en la forma en que han conseguido la supremacía cuántica. Los ordenadores clásicos se comunican entre ellos a través de «bits», el lenguaje binario que, a través de complejos cálculos matemáticos, convierte la información en unos y ceros. Sin embargo, en computación cuántica, los sistemas «hablan» en «cúbits», que pueden ser 1 y 0 a la vez (por el mismo principio que rige al famoso gato Schrodinger, vivo y muerto al mismo tiempo), lo que multiplica exponencialmente el rendimiento de esta tecnología. Es decir, con muchas menos operaciones, se pueden hacer cálculos mucho más potentes, lo que en la era del Big Data es una ventaja enorme (de ahí que grandes empresas como Google e IBM estén invirtiendo ingentes cantidades de dinero en esta tecnología). Las formas de conseguir la supremacía cuántica. Para conseguir estos cúbits teóricos hay que crear un sistema físico que los transporte y los manipule. Google lo consiguió a través de cúbits superconductores. Pero hay otras formas: desde trampas de iones a las exóticas cuasipartículas de Majorana, todos intentan crear un sistema que demuestre que estas nuevas máquinas cuánticas pueden realizar una tarea o un cálculo que esté completamente fuera de las capacidades de cualquier ordenador convencional. China lo ha logrado a través de un circuito óptico del muestreo de bosones: empleando una extraña propiedad cuántica de las partículas de luz (fotones), que viajan aleatoriamente en diferentes direcciones dentro de un circuito. «No han creado un ordenador cuántico per se, sino un circuito óptico muy sofisticado que trabaja con luz cuántica», explica a ABC Juan José García Ripoll, físico teórico del Instituto de Física Fundamental (dependiente del CSIC). «Pero se trata de un experimento extremadamente difícil de llevar a cabo por la cantidad de elementos que tiene, por el uso de luz cuántica y la dificultad de mantener la coherencia cuántica de todo el sistema». Este circuito es, de forma muy simple, algo así como una máquina de Galton: imaginemos un tablero vertical con varias filas de clavos. Desde arriba, caen bolas que botan de forma aleatoria sobre los clavos, llevando a las pelotas hacia un camino u otro hasta alcanzar la parte inferior del tablero. En el muestreo de bosones, las bolas serían los fotones (que son un tipo de bosón) y, los clavos, dispositivos ópticos o espejos, que hacen que la luz se propague en diferentes direcciones. Sin embargo, las «pelotas» de luz cuántica no se comportan igual que las bolas físicas: los fotones poseen una extraña propiedad que se muestra cuando viajan a través de un divisor de haz (un espejo de los anteriores), que divide un solo rayo en dos que se propagan en diferentes direcciones. De forma paralela, si dos fotones idénticos golpean el espejo exactamente al mismo tiempo, no se separan entre sí y viajan en la misma dirección. Es decir, como si esas bolas físicas pudieran, en cada encuentro con un espejo, multiplicarse en dos o, en caso de llegar al mismo a la vez, convertirse en una sola. La cuestión aquí sería averiguar los posibles caminos de los fotones en el circuito y su destino final (cuántos salen y por dónde), una tarea que se complica cuantas más partículas de luz, entradas, salidas, caminos y espejos hay en el circuito, además de por la extraña capacidad de los fotones de dividirse o agruparse de forma aleatoria. De ahí que a las computadoras clásicas les cueste mucho más trabajo elaborar estos cálculos. Sin embargo, al sistema cuántico chino la tarea solo le ha costado 200 segundos, consiguiendo así la supremacía cuántica. «Estudiar experimentalmente todo eso y sacar toda la estadística es laborioso, pero ellos han demostrado que es posible», afirma García Ripoll. En concreto, el dispositivo de muestreo de bosones llamado Jiuzhang utilizó pulsos de láser enviados a un laberinto de 100 entradas, 100 salidas, 300 divisores de haz y 75 espejos. Su ordenador cuántico logró detectar hasta 76 fotones en cada experimento, con una media de 43 fotones de 100 (lo que equivaldría a 100 cúbits, casi el doble que en la versión de Google, que contaba con 53, según explica en su blog el físico Francisco R. Villatoro). El equipo chino creador de Jiuzhang afirma que tiene una fiabilidad del 99%. Con respecto a las diferencias del sistema de Google, García Ripoll señala: «El sistema no es reconfigurable, por lo que cada vez que hacen el experimento tienen que modificar a mano toda la configuración. Aun así es un equipo muy sofisticado y, en este sentido, es similar a la filosofía del experimento de Google con su ordenador cuántico, que generaba una sucesión de cúbits aleatorios que es muy difícil de reproducir de forma clásica». También ambos comparten su objetivo ad hoc: no tienen aplicaciones directas salvo demostrar la supremacía cuántica. Un experimento arduo. Hace una década, los físicos teóricos Scott Aaronson y Alex Arkhipov demostraron que el muestreo de bosones solo era posible con equipos cuánticos y que, además, sería la forma más fácil de conseguir la supremacía cuántica deseada. La segunda hipótesis estaba errada, pero no así la primera, si bien algunos no confiaron en sus tesis. «Este estudio demuestra que es factible llegar a la supremacía cuántica usando muestreo de bosones fotónicos, algo que mucha gente había dudado, y que representa una ruta de hardware completamente diferente a la de los cúbits superconductores que usó Google», explica a NewScientist el propio Aaronson. Pero, a pesar de ser un gran paso en la computación cuántica, la humanidad aún se encuentra lejos de conseguir ordenadores cuánticos «de sobremesa»: el dispositivo solo sirve para esta tarea de muestreo de bosones, es decir, algo extremadamente específico sin mucho más recorrido práctico. «No significa construir una computadora cuántica escalable, ni un ordenador cuántico universal o útil», apunta Aaronson. «No es un ordenador cuántico, sino un equipo mucho más específico que pertenece al ámbito de la física teórica. Es un experimento que en sí mismo no es útil, aunque se puede reformatear para aplicarlo a algún ámbito específico, como la química cuántica. En realidad es un aparato para llevar la mecánica cuántica a límites que hasta hace poco no se podían alcanzar y conseguir la supremacía cuántica. No es computacionalmente útil, pero es un hito científico impresionante», señala García Ripoll por su parte. El siguiente paso, según los investigadores chinos, será, en efecto, conseguir pausar el experimento, realizar mediciones y redirigir a los fotones por el circuito, aunque será un logro extraordinariamente difícil de conseguir. Pero pensemos que, hace apenas cinco años, la supremacía cuántica aún estaba muy lejos. Y hoy la humanidad la ha conseguido dos veces. De momento.

2 Comentarios

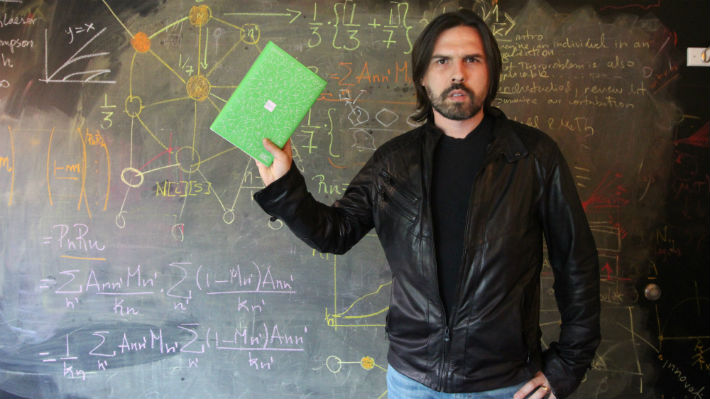

LAMONCLOA.GOB.ES El presidente del Gobierno, Pedro Sánchez, ha presentado en el Palacio de la Moncloa la Estrategia Nacional de Inteligencia Artificial (ENIA), una de las propuestas fundamentales del Plan España Digital 2025 lanzado el pasado mes de julio. El objetivo de esta Estrategia es generar un entorno de confianza respecto al desarrollo de una Inteligencia Artificial (IA) inclusiva, sostenible y que ponga a la ciudadanía en el centro. La Estrategia Nacional de Inteligencia Artificial "busca situar a nuestro país en la línea de los países líderes en la investigación y el uso de una Inteligencia Artificial confiable al servicio del desarrollo económico y social, al servicio de nuestra modernización económica", tal y como ha explicado Pedro Sánchez. A la presentación de la Estrategia Nacional de Inteligencia Artificial han acudido, además del presidente del Gobierno, la vicepresidenta tercera y ministra de Asuntos Económicos y Transformación Digital, Nadia Calviño; la ministra de Educación y Formación Profesional, Isabel Celaá; y la ministra de Industria, Comercio y Turismo, Reyes Maroto. El acto ha contado con las intervenciones de Pilar Manchón, directora senior de estrategia de investigación en IA en Google; de Rafael Yuste, neurobiólogo impulsor del proyecto BRAIN de Estados Unidos y de la International Brain Initiative; de Inmaculada Martínez, pionera tecnológica en Inteligencia Artificial y digitalización; y de Pablo Rodríguez, investigador en desarrollos tecnológicos a largo plazo sobre tecnologías disruptivas. La IA como vector de crecimiento económico La Estrategia Nacional de Inteligencia Artificial es el componente 16 del Plan de Recuperación, Transformación y Resiliencia de la economía española y nace como un marco dinámico, flexible y abierto a la aportación de empresas, ciudadanos, agentes sociales y resto de Administraciones. LFoto: Pool Moncloa/Fernando Calvoa IA es una de las tecnologías con mayor potencial de transformación e impacto en todas las áreas de actividad productiva, además de suponer un motor de innovación y un importante vector de generación de empleo de calidad. Al respecto, Pedro Sánchez ha destacado que con "la Inteligencia Artificial se transformará el mercado laboral español y aumentará el número de empleos". La estrategia resultará fundamental de cara a incorporar la IA como factor de mejora de la competitividad y el desarrollo social, y lo hará, además, impulsando desarrollos tecnológicos que ayuden a proyectar el uso de la lengua española en los ámbitos de aplicación de la IA. La puesta en marcha de esta estrategia movilizará una inversión pública de 600 millones de euros en el período 2021-2023, a los que se añadirá la aportación del fondo Next Tech de naturaleza público-privada y que persigue impulsar el emprendimiento en tecnologías digitales habilitadoras. En los Presupuestos Generales del Estado para 2021 se prevén 330 millones de euros para Inteligencia Artificial y Economía del Dato. Un plan con seis ejes estratégicos La ENIA cuenta con seis ejes estratégicos. En primer lugar, el impulso de la investigación científica, el desarrollo tecnológico y la innovación en Inteligencia Artificial; en segundo lugar, el fomento de las capacidades digitales, el desarrollo del talento nacional y la atracción del internacional; el tercero, el desarrollo de plataformas de datos e infraestructuras tecnológicas que den soporte a la IA; en cuarto, integrar la IA en las cadenas de valor para transformar el tejido económico; en quinto, impulsar el uso de la IA en la Administración Pública y en las misiones estratégicas nacionales y, finalmente, el establecimiento de un marco ético y normativo que garantice la protección de los derechos individuales y colectivos, con el bienestar social y la sostenibilidad como ejes vertebradores. En cada uno de estos seis ejes se recogen una serie de medidas, hasta un total de 30. Por ejemplo, el impulso a la investigación en IA; la promoción de nuevos centros nacionales de desarrollo tecnológico multidisciplinar con especial foco en neurotecnologías, o la creación de programas de ayudas a empresas para el desarrollo de soluciones en IA y datos. Asimismo, se propone la puesta en marcha de una mayor oferta formativa universitaria y en formación profesional o la puesta en marcha del Programa "SpAIn Talent Hub". Se creará la Oficina del Dato a nivel nacional y la figura del 'Chief Data Officer', la creación de espacios compartidos de datos y repositorios descentralizados y accesibles, participando en la creación de repositorios de datos a nivel de la UE. Se reforzarán las capacidades de supercomputación y se impulsará el Plan Nacional de Tecnologías del Lenguaje. Además, se lanzarán programas de ayudas para empresas con el fin de incorporar la IA en los procesos productivos y de las cadenas de valor y se lanzará el "Fondo Next Tech" de capital riesgo público-privado para impulsar el emprendimiento digital y el crecimiento de empresas. Se desarrollará un programa de algoritmos verdes. En el ámbito del sector público, se pondrá en marcha un laboratorio de innovación para nuevos servicios y aplicaciones de la IA (GobTechLab) y se incorporará la IA a la Administración Pública para mejorar la eficiencia. Se impulsará una gestión pública basada en datos. Y, finalmente, por el lado ético y normativo de protección de derechos, se pondrán en marcha observatorios para evaluar el impacto social de los algoritmos, se desarrollará un sello nacional de calidad en IA y se elaborará una Carta de Derechos Digitales. Por qué es necesaria la ENIA El despliegue efectivo de la Inteligencia Artificial es crítico para afrontar la necesaria transformación digital de la economía. En ese sentido, la IA aportó 1.760 millones de euros al PIB mundial en 2018 y se estima que su contribución superará los 14 billones de euros para el año 2030. Se trata, por tanto, de una tecnología en auge caracterizada por un gran potencial de transformación desde el punto de vista tecnológico, económico, ambiental y social dada su penetración en todos los sectores, así como su elevada capacidad de impacto, rápido crecimiento y contribución a la mejora de la competitividad. En la actualidad, hay sectores industriales con un margen de mejora potencial para aprovechar este despliegue, tales como la industria de materiales, el transporte y la movilidad, la sanidad o el sector financiero, entre otros. En ese sentido, la IA implicará la posibilidad de mejorar la eficiencia de procesos y la dotación de servicios personalizados a la ciudadanía. La ENIA permitirá mejorar la preparación del tejido productivo español de cara a impulsar su competitividad en el plano europeo e internacional. Se trata, por tanto, de un paso fundamental en la apuesta por la transformación digital de la economía y la sociedad a través del desarrollo de tecnologías disruptivas de alto valor añadido. España afronta el reto del despliegue de la IA contando con determinadas ventajas competitivas en distintos sectores estratégicos. Así, España cuenta ya con instalaciones de alto rendimiento computacional para el procesado de cantidades masivas de datos y con excelentes grupos de I+D+I tanto públicos como privados. VER y DESCARGAR No cabe esconder las decisiones estratégicas de la compañía tras un velo de documentos, datos y probabilidades.Enlace al artículo en CINCO DÍAS Leo, por sugerencia de Andrés Ortega, el libro de “Radical Uncertainty: Decision-Making Beyond the Numbers” escrito por John Kay y Lord Mervyn King. Se publicó en marzo de 2020, poco antes de la expansión global de la pandemia y, quizás por este motivo, me resulta de gran interés para la dirección estratégica. John Kay es una referencia académica de primer orden y un ponente habitual en conferencias, encuentros TED y otros espacios divulgativos. Lord Mervyn King fue el gobernador del Banco de Inglaterra entre 2003 y 2013. Vivió en primera persona la gran recensión de 2008 y su figura ha sido alabada por su templanza, más allá de las decisiones concretas. En tiempos de populismo financiero, no es poca virtud. Me interesa el libro porque ofrece una visión panorámica sobre la nueva estructura de la economía global. Desde 2008, se han consolidado dinámicas concretas: la reordenación del comercio global, el auge de China, la transformación digital, la industria de los datos y, sobre todo, la incertidumbre. Los autores defienden que el modo en que hemos estudiado y pensado la incertidumbre ha dificultado la toma de decisiones. El mundo carece de un sentido racional, una pauta que pueda reducir las decisiones a probabilidades (0 y 1, sí y no, blanco y negro) o un sentido teleológico. Más aún, los autores sostienen que las probabilidades ni siquiera existen en la mayoría de las decisiones económicas, empresariales y políticas. Con el mítico ejemplo de la moneda, se entiende bien que las decisiones basadas en cálculos matemáticos sin añadir el criterio social, histórico o antropológico fracasan. Tras la lectura, encuentro una vertiente aplicada, tres lecciones que comparto ahora. La arrogancia del dato. La adquisición de información ordenada y distribuida en tablas y hojas de dato ha inundado las mesas de la alta dirección. El dato indica. El dato señala. El dato asegura. Es un error transcendental en la medida en el que dato oculta un diseño de investigación, una pregunta, un paradigma. El dato no opera en el vacío y pensar que el dato es objetivo, prístino o probo impide entender la estructura que opera tras él. Los datos son respuestas sistemáticas, pero no son la verdad. En su dimensión política, los data politics ya se preocupan por los sesgos cognitivos que se generan en la creación de políticas públicas basadas en datos, pero sin contexto público o social. Del mismo modo, aquellas organizaciones que consideren que tienen razón porque tienen buenos datos desconocen el impacto de la incertidumbre radical en la cuenta de resultados. El criterio social. El acceso a las bases de datos tiende a convertirse en una commodity, ya que numerosas multinacionales ofrecen el mismo servicio. Será difícil diferenciarse por la vía de la acumulación y captura de datos, por lo que defiendo la recuperación de la noción de inteligencia directiva. El directivo tiene que ampliar su conocimiento en disciplinas sociales, tales como la historia o la antropología. La máquina ya extrae datos, pero carece de conocimiento social para liderar proyectos, empatizar con los clientes o generar confianza social. Ahí estará el valor diferencial de un buen directivo, puesto que los datos -acertados o no- se devalúan ante fenómenos inesperados. Así, defiendo que la captura de información puede externalizarse (empresas de servicios que provean de fuentes y tendencias), pero no así la toma de decisiones sobre qué preguntar a los datos, qué corrientes o disciplinas mezclar o qué dato nos oculta la verdadera intención del comprador o el usuario. Sugiero aquí leer la última obra publicada de Hans Ulrich Gumbrecht, quien desde la filosofía política y la sociología explica mejor que ningún otro informe las claves del éxito de la industria tecnológica de Silicon Valley. No busquen la idea de espíritu del tiempo en los balances o estados financieros. Cisnes negros, dragones y rinocerontes grises. A menudo, evaluamos a posteriori y pensamos que las decisiones que hemos tomado responden a modelos y taxonomías preexistentes. Las empresas innovadoras aciertan cuando rompen los cánones e inventan nuevos mercados, bien sean necesidades reales o estimulada. La virtud de la incertidumbre radical consiste conocer bien las estrategias triple A: anticipar, adaptar y actuar. Y, en este último punto, la acción exitosa requiere cualidades de liderazgo por encima de avales numéricos. De nuevo, aquí recurro a las reflexiones de Roger Martin para defender que el capitalismo creativo. El dato es intensivo en rutina y ahí es imbatible. Por eso, el directivo debe aportar otras cualidades a la organización: colaboración, credibilidad, confianza y reputación. En síntesis, la incertidumbre radical, ya antes de la pandemia, es el estado natural de los negocios. No cabe esconder las decisiones estratégicas de la compañía tras un velo de documentos, datos y probabilidades. La falsa sensación de seguridad que desprenden los planes de expansión, las hojas de cálculo o las previsiones perjudica a la organización y convierte al directivo en un mero ejecutor de programas. Ahí, además, la inteligencia artificial ofrece mejores resultados. No es, por tanto, el camino para resolver las crisis ni para transformar las instituciones. Ojalá la lectura del libro -con o sin COVID19 en el año 2021- nos permita dirigir las organizaciones con nuevas ideas. En este encuentro, enmarcado en el Foro Telos 2020 y desde el auditorio de TELEFONICA, la periodista Marta Peirano entrevista al analista geopolítico Pedro Baños y conversan sobre su nuevo libro, ‘El dominio mental’. Tras sus exitosos ‘Así se domina el mundo’ (traducido a 11 idiomas) y ‘El dominio mundial’, ambos publicados por Ariel, Pedro Baños dirige ahora su atención a las técnicas que el poder utiliza para controlar nuestras emociones porque ‘quien consigue controlar nuestra mente controla el poder’. Desarrolla herramientas capaces de convertir en narrativas enormes cantidades de información desde un mar de datos conocido como Big Data, donde es capas de “leer” patrones en múltiples y heterogéneas interconexiones, efectuando gravitantes predicciones aplicables a sistemas naturales, sociales y económicos.VÍA CONICYT. (Publicado 20-04-2016 y actualizado) César Hidalgo (34) habla muy rápido. Quizás demasiado para los ojos de un observador casual, pero pronto sus palabras comienzan a hacer sentido y sus ideas capturan la atención de los asistentes al evento final del campamento de investigación B3 (Bits, Bots & Behavior), que reúne a estudiantes del prestigioso Media Lab del Instituto Tecnológico de Massachusetts (MIT) con sus pares chilenos. Allí el científico nacional conversó con Explora (Programa Nacional de Divulgación y Valoración de la Ciencia y Tecnologia, del Gobierno de Chile) sobre sus motivaciones, proyectos y las infinitas posibilidades de los datos, su principal línea de investigación. “El Media Lab es un laboratorio de invención. Lo que buscamos es generar herramientas que produzcan un impacto positivo en el mundo”, cuenta el doctor en Física en la Universidad de Notre Dame (Francia) y profesor asociado de Ciencia y Artes Mediales del MIT, donde lidera el grupo de Macro Conexiones. Su labor se centra en comprender la evolución de la información en los sistemas naturales, sociales y económicos; además de desarrollar motores de visualización de enormes cantidades de datos, las que se hacen difíciles de manejar considerando el creciente volumen de información disponible (Big Data). El físico formado en la Universidad Católica de Chile, quien vive en la ciudad de Somerville en el estado de Massachusetts junto a su esposa Anna y su pequeña hija Iris, acaba de lanzar el libro “Por qué la información crece” (Why Information Grows. Basic Books, 2015). Coescribió “Atlas de la Complejidad Económica” (The Atlas of Economic Complexity. MIT Press, 2014) y suma más de cinco mil citas en sus publicaciones académicas y 8 millones de visitas en sus motores de visualización, en 2021 publicará "How Humans Judge Machines" Sistemas Complejos y Big Data La definición de un sistema complejo señala que se compone de “varias partes interconectadas o entrelazadas cuyos vínculos crean información adicional”, que no era visible con anterioridad por el observador. De las interacciones entre los elementos “surgen propiedades nuevas que no pueden explicarse a partir de las propiedades de los elementos aislados”. Es decir, el todo es más que la suma de sus partes. ¿Cómo definiría usted un sistema complejo? Son sistemas que tienen muchas partes, donde todas son distintas. Son heterogéneos con patrones de conexiones que no son triviales, es decir, no como una grilla sino que hay nodos que están más conectados, otros poco vinculados, algunos que forman triángulos, unos solos, etc. Además tienen la capacidad de adaptarse y evolucionar. Por ejemplo, las sociedades, la economía e incluso la manera en que se comportan las proteínas dentro de la célula son sistemas complejos. Estos no se pueden entender a través de promedios, o los totales, o los números simples. Si yo quiero hallar la diferencia entre un hipopótamo y otro animal de peso similar como un búfalo grande, si lo que tomo es su peso, porcentaje de agua en el cuerpo y de proteínas, no podría diferenciarlos.Pero si miro su genética y empiezo a ver estas cosas en mayor detalle, la heterogeneidad de las partes, cómo interactúan, de qué manera se conectan, cuál parte “prende” a un gen o lo “apaga” en un animal y el otro, ya en ese contexto voy a ser capaz de distinguirlos entre ellos. ¿Qué predicciones teóricas sociales se desprenden de los datos que analizas? Hay cinco que hemos probado que son bastante fuertes, tres de ellas son sobre el desarrollo industrial de los países. La primera es que si uno sabe el set de productos que una determinada nación hace, uno puede predecir los que hará en el futuro; la segunda es que si además conozco qué tan complejos son esos bienes, uno consigue pronosticar qué nivel de ingresos tendrá y así cuál será el crecimiento próximo; la tercera es que con el mismo conocimiento basal, uno logra anticipar el nivel de desigualdad que sufrirá. Esas tres predicciones son del mismo tema: si uno sabe qué productos genera un país, unos puede predecir qué va a hacer después, cuánto va a crecer y qué tan desigual es. ¿En qué área esto se hace más evidente? En el ámbito de la evolución de la información, en una escala de tiempo más larga -no en los últimos 50 años sino que en los últimos miles de años- hemos sido capaces de demostrar que cuando los medios de comunicación cambian, se introducen transformaciones abruptas en la tasa de personas memorables que se recuerdan. Por ejemplo, antes de la invención de la imprenta no recordamos a casi ningún artista o científico; después de ella, evocamos a muchos científicos, artistas, pintores y compositores. Después de la creación de la televisión empezamos a retener actores, que existieron siempre desde la antigua Grecia, pero nunca fueron conocidos hasta el desarrollo de la pantalla, porque no había un instrumento capaz de grabar la interpretación de una obra. Entonces los medios de comunicación transforman qué recordamos y qué tanto recordamos. ¿Cómo detecta narrativas en el mar de información que es el Big Data? Transformo datos en historias, en eso hay una parte de ciencia y una de arte. En lo científico lo primero que trato de hacer es encontrar los patrones comparativos más simples en los datos que te puedan empezar a generar una historia. Porque no solo quiero generar una historia, sino que ésta sea lo suficientemente simple para que la gente entienda. Una manera de buscar esto es encontrando outlayers: al buscar tendencias, hay lugares, personas o grupos que se desvían de esa tendencia, y uno se empieza a preguntar por qué. Muchas veces vas a buscar datos para explicar por qué sucede esto. La otra manera es generando herramientas de visualización que produzcan largas narrativas con muchos datos del mismo lugar, entidad o empresa, y al ver esas relatos como humano, uno empieza a hacer conexiones que no podría hacer si uno ve un gráfico solo, sino que ocurren entre las líneas al pasar de un gráfico a otro. Esto ayuda a extraer narrativas. Mientras que en la parte de arte, uno tiene herramientas, hay una sensibilidad, conoce algo contextual sobre ese sistema que te ayuda a darte cuenta cuál sería la pregunta interesante. Chile en el Mundo. ¿Qué predicen los datos sobre la economía nacional? Está anclada al precio internacional de los minerales, así que el futuro de la economía chilena es algo conocido. Además tiene una complejidad intermedia puesto que el recurso mineral es básicamente el que determina el nivel de ingreso y también el de desigualdad. Es importante entender en ese contexto que en Chile este último es bien alto, no solo por asuntos institucionales o culturales, sino que también porque el set de industrias que la nación tiene generan mucha riqueza con una cantidad de empleo muy baja, puesto que corresponden a industrias de capital intensivas. Es decir, con alta concentración del poder, al tener estructuras jerárquicas. No es lo mismo manejar una minera, que una empresa de software. En una mina requieres de un escalafón porque quieres que las personas respeten los protocolos de seguridad, los horarios, etc. En cambio en una compañía de software todo es más creativo y fluido. A su juicio ¿Ha cambiado en algo esto en Chile en el último tiempo? Yo veo que hay una parte importante de los chilenos, como la Generación X o los Millennials, que están empujando de distintas maneras el desarrollo de industrias no tradicionales en el país. En ese punto Chile no tiene nada que envidiarle a otras latitudes. ¿Cuál es su análisis de la memoria colectiva chilena? Nosotros la vemos de una manera bastante estrecha porque la ordenamos empíricamente basándonos en las personas que nacieron en un país que son globalmente famosas. Entonces, la memoria colectiva de Chile incluye a Pablo Neruda, Iván Zamorano, Marcelo Ríos, pero también incluye a Pinochet y Allende. Si uno se sube a un taxi en Moscú o en Tokio, en general los tres personajes chilenos que conocen son Neruda, Pinochet y Allende. De cierta manera los individuos que son reconocidos globalmente te cuentan cuál es la narrativa de esa nación y eso es lo que queda en el recuerdo colectivo. Son las cosas que por un lado nosotros guardamos en los medios de información, pero por otra parte son aquellas que repetimos en los actos de comunicación, y esa reproducción es una medida cuantitativa de lo que es la fama. La memoria colectiva de Chile está centrada en la política, el deporte y la escritura; acorde al nivel de desarrollo cultural que tenemos, que es intermedio. Este país no ha generado científicos famosos, inventores o cineastas célebres, porque nuestro desarrollo cultural es en las categorías más comunes, las más fáciles de alcanzar. Todos los países tienen un político famoso, por ejemplo Zimbabwe con Mugabe, Sudáfrica con Mandela, también hay escritores; Colombia con García Márquez… pero ¿conocemos un científico famoso de Colombia? No todavía. ¿Se debe así al nivel de desarrollo del país? ¿Y qué rol juega la ciencia? Hay una escalera de desarrollo cultural que va de las formas más simples y comunes, a las más complejas; los países que están más arriba en esta escalera son naciones que ya tienen un output muy grande en las formas más simples, se encuentran en un estadio de desarrollo más alto que nosotros. De hecho, hay una ley logarítmica que dice que si tú vas a ser un país que va a producir un científico, por cada uno de ellos vas a tener 10 escritores afamados; y por cada 10 hombres de ciencia gloriosos vas a engendrar un inventor famoso. En un dataset que hicimos de personas famosas en el mundo de acuerdo a Wikipedia, de 11.334 personas listadas, Chile tenía 27. Presentación: "How Humans Judge Machines"  Sobre este curso Este MOOC estudia y analiza qué hay detrás de muchas de las acciones violentas y terroristas que, en principio, resultan incomprensibles para la mayoría de los ciudadanos. En muchas ocasiones, estos actos se desatan de procesos previos de radicalización de diferente índole. Procesos que no solo son significativos porque puedan acabar en violencia, sino porque también revelan que la radicalización ideológica o ideológico-religiosa es, en sí misma, un asunto público de gran relevancia que atañe a la cohesión social y a la polarización de nuestras sociedades democráticas. Si como ciudadano te interesa lo que ocurre en la sociedad y quieres tener un conocimiento riguroso acerca de lo que hay detrás de muchos de los actos violentos que suceden, te animamos a que analices con nosotros los procesos de radicalización violenta. En este curso contamos con grandes expertos y profesionales que trabajan en la materia y que provienen de diferentes ámbitos: Cuerpo Nacional de Policía, Guardia Civil, Instituciones Penitenciarias y Universidad, Judicatura y Fiscalía. El amplio abanico profesional que abarca este MOOC te ofrecerá puntos de vista diversos sobre la problemática estudiada. Qué vas a aprenderLos contenidos del curso se centran en:

Requisitos No es necesario que tengas conocimientos previos en la materia. Este curso te ofrecerá los contenidos básicos para que sigas investigando, ya que abarca todos los ámbitos necesarios para obtener una visión introductoria, sólida y global sobre el fenómeno de radicalización. Es especialmente interesante para profesionales que trabajan con jóvenes y que necesiten tener un conocimiento más profundo del fenómeno que les ayude en el desempeño de sus tareas. También es recomendable para estudiantes del ámbito de las ciencias sociales, ya que les permite tener un conocimiento riguroso de lo que hay detrás del terrorismo y de las acciones violentas. Es de gran utilidad para profesionales de la Justicia. Y además, puede realizarlo cualquier persona que quiera conocer los problemas que afectan profundamente a la sociedad y al bienestar público. Profesorado Rut Bermejo Casado. Es licenciada en Derecho (UCM, 1996) y en Ciencias Políticas y Sociología (UNED, 2000) y Doctora en Estudios Europeos (URJC, 2007) y actualmente es Profesora Contratada Doctora en la Universidad Rey Juan Carlos de Madrid, donde desde el año 2004 trabaja en el análisis de políticas públicas vinculadas al ámbito de justicia e interior y es experta en metodología de investigación. Isabel Bazaga Fernández. Es licenciada en Ciencias Políticas y Sociología (UCM, 1988) y Doctora en Ciencia Política (UCM, 2015). Actualmente es Profesora Titular de Universidad en la Universidad Rey Juan Carlos de Madrid e investigadora permanente del Instituto Universitario de Investigación Ortega y Gasset de Madrid. Manuel Tamayo Sáez. Es licenciado Sociología (UCM) y Doctor en Sociología (UCM, 2002). Actualmente es Profesor Contratado Doctor en la Universidad Rey Juan Carlos de Madrid e investigador permanente del Instituto Universitario de Investigación Ortega y Gasset de Madrid. ENLACE al curso. El mundo del Machine Learning... un mundo complejo y muy extenso, pero ¿por dónde empezar? En este webinar se verá una introducción al Machine Learning y a las principales técnicas que se usan hoy en día. Además de hacer un repaso sobre los pilares en los que se basa el Machine Learning junto a los principales problemas que la industria afronta ahora mismo. PONENTE: Alejandro Díaz es Ingeniero Aeroespacial. Centró sus estudios posteriormente en Machine Learning y Inteligencia Artificial y Software en Berlín. Ha trabajado en el departamento de I+D de Altran como desarrollador Python, posteriormente trabajó como Machine Learning Engineer para una startup estadounidense y finalmente en BBVA. Actualmente trabaja en Australia donde continúa formándose como especialista en Data Science. Apuntate en este ENLACE. ¿Qué es enlightED?Reinventar la educación en un mundo digitalFundación Telefónica, IE University, Fundación Santillana y South Summit se vuelven a unir para organizar, con un novedoso formato digital, enlightED Virtual Edition 2020. Será la tercera edición de la conferencia mundial que reúne a destacados expertos internacionales en educación, tecnología e innovación para compartir soluciones a los retos que la COVID-19 ha planteado al aprendizaje y al trabajo en nuestras sociedades, y extraer conclusiones prácticas en torno al gran debate sobre la educación en la era digital. En los últimos años, el big data se ha convertido en una de las disciplinas de moda. Sus aplicaciones abarcan numerosas áreas y, entre ellas, cuestiones de gran importancia para la ciudadanía como la salud y la investigación biomédica. ¿Cuáles son los últimos avances en este campo? ¿Qué retos enfrentan las personas profesionales en este ámbito? ¿Qué matemáticas emplean? El próximo miércoles 7 de octubre a las 9 de la mañana Nuria Oliver (Data-Pop Alliance, Vodafone Institute y European Laboratory for Learning and Intelligent Systems) y María Xosé (Coté) Rodríguez Álvarez (Basque Center for Applied Mathematics, BCAM) abordarán estos temas desde su experiencia profesional.

El evento se celebrará en formato online, y está abierto a la participación del público, que podrá realizar sus preguntas a las ponentes. Es necesaria la inscripción previa, que ya puede realizarse en la web de Eje&Con. Las dos ponentes son investigadoras en activo a nivel internacional. Nuria Oliver, ingeniera de Telecomunicación por la Universidad Politécnica de Madrid (UPM) y doctora en Inteligencia Artificial por el Massachusetts Institute of Technology (MIT), suma 25 años de experiencia investigadora en diversas instituciones: MIT, Microsoft Research (Redmond, WA), y como la primera directora científica mujer en Telefónica I + D (2007-2016) y la primera directora de investigación en ciencias de datos en Vodafone (2017-2019). Su trabajo se centra en el modelado computacional del comportamiento humano usando técnicas de inteligencia artificial, la interacción persona-máquina, la informática móvil y el análisis de big data. Oliver ha aplicado estas áreas a cuestiones de salud pública; recientemente, como comisionada para Presidencia de la Generalitat Valenciana para Inteligencia Artificial y las Ciencias de Datos en la lucha contra la COVID-19, y, en anteriores ocasiones, lo hizo durante el brote de gripe A en México, el brote de ébola de 2017 y la erradicación, a través de las ciencias de datos, de la malaria en Mozambique. Por su lado, Coté Rodríguez Álvarez es Ikerbasque Research Fellow en el BCAM – Basque Center for Applied Mathematics (Bilbao). Obtuvo el doctorado en Matemáticas por la Universidade de Santiago de Compostela (USC) en el año 2011. Antes, entre el 2000 y el 2005, trabajó en el sector privado, concretamente, en el sector de las Tecnologías de la Información. Su primer contacto con el mundo académico e investigador fue como profesora asociada en la Universidade de Vigo (2006-2007) y, posteriormente, como gestora de proyectos de I + D en la USC (2008-2010). Del 2010 al 2013 trabajó como bioestadística en la Unidad de Epidemiología Clínica del Hospital Universitario de Santiago de Compostela, y entre 2013 y 2016 tuvo un contrato postdoctoral en la UVIGO durante el cual realizó estancias de investigación en distintas universidades europeas. En octubre del 2016 se incorporó al BCAM. Su investigación se centra en el desarrollo de métodos estadísticos con una fuerte componente aplicada y multidisciplinar. En particular, ha trabajado en modelos para la evaluación estadística del valor diagnóstico y/o pronóstico de biomarcadores clínicos, y en modelos espacio-temporales para el análisis de experimentos de campo agrícolas. FUNDACIÓN TELEFÓNICA La IA sigue rodeada de un halo de misterio e incertidumbre propiciado por los prejuicios asociados a la ciencia ficción. Sin embargo, sus expectativas de crecimiento e impacto social, en todas las áreas, son cada vez mayores. Así, la realidad y la ficción se mezclan en un cruce de caminos en el que resurgen profundos pensamientos filosóficos como qué es la consciencia y si las máquinas podrían llegar a tenerla. Richard Benjamins e Idoia Salazar, autores de “El mito del algoritmo”, han presentado el libro en la Fundación Telefónica moderados por el periodista Jaime García Cantero. Grandes personalidades, como Elon Musk o Stephen Hawking, han alertado sobre los peligros y graves riesgos de la IA, alimentando la visión apocalíptica de un mundo futuro dominado por las ‘máquinas’. ¿Cuánto hay de verdad en esto? ¿Llegarán las máquinas a acabar con la humanidad, tal y como la conocemos? ¿Es posible que tengan sentimientos? ¿Nos quitarán puestos de trabajo? ¿Pueden ayudarnos a combatir y predecir pandemias o desastres naturales? Estas son algunas de las preguntas que Richard Benjamins e Idoia Salazar abordan en esta obra. Usando un lenguaje sencillo y esclarecedor, exponen algunos de los principales “cuentos”, y los aclaran —“cuentas”— aportando, además, de primera mano, opiniones de algunos de los expertos más relevantes a nivel internacional. Un proyecto editorial que ha conseguido posicionarse como número 1 en ventas de libros en Amazon en, al menos, 3 categorías. En este encuentro se ha contado además con la participación de varios expertos como Leontxo García, experto en Inteligencia Artificial aplicada al ajedrez; Borja Adsuara, abogado experto en Derecho Digital; Ángel Gómez de Agreda, coronel de Ejército del Aire y Director del área de Defensa y Seguridad de OdiseIA; y Teresa Rodríguez de las Heras, miembro del Miembro del European Union Commission Expert Group on Liability/Technologies formation on Advanced Robots, Artificial Intelligence, and Internet of Things. ENLACE al encuentro. |

José Manuel Rábade RocaPh.D. Ciudadano crítico. Trabajando e investigando en seguridad, pero ante todo abierto al cambio. Archivos

Noviembre 2023

|

Canal RSS

Canal RSS